La journée du 10 décembre à l’Université de Limoges promet une chose rare dans les débats sur l’intelligence artificielle : revenir au fonctionnement réel de ces systèmes avant de parler d’éthique. C’est ce que portera notamment Marianne Dabbadie, chercheuse associée à l’Université Paul-Valéry de Montpellier, spécialiste du Traitement Automatique des Langues Naturelles. Son angle est simple : on ne peut réguler que ce que l’on comprend.

Colloque du CREOP, université de Limoges

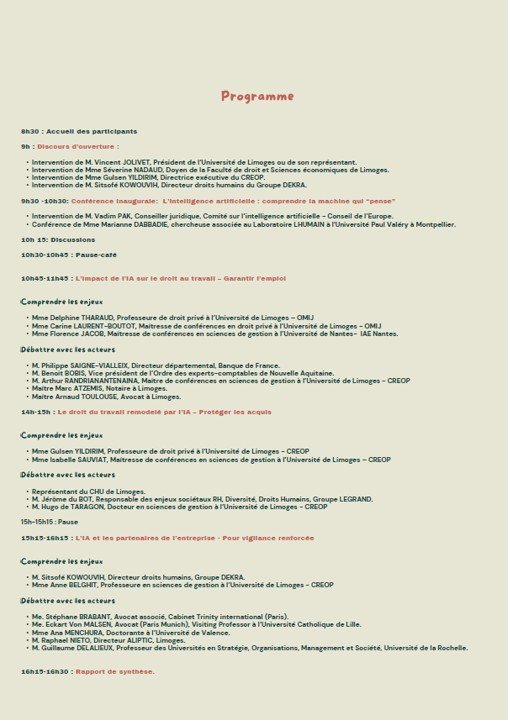

Sur l’invitation de Mme Gulsen Yildirim, Professeure des universités en droit privé, Directrice exécutive du CREOP (Centre de recherches sur l’Entreprise, les Organisations et le Patrimoine – UR 15561), Marianne Dabbadie a été sollicitée pour la conférence inaugurale du Colloque annuel du CREOP, en binôme avec M. Vadim Pak, Conseiller juridique, membre du Comité sur l’intelligence artificielle au Conseil de l’Europe.

Face aux discours rassurants ou menaçants, sa conférence va ouvrir le capot des grands modèles de langage. Comment ChatGPT ou d’autres IA génératives produisent-ils une réponse ? Pas en “comprenant”, mais en calculant, mot après mot, la probabilité la plus plausible selon d’immenses corpus d’entraînement. Cette logique probabiliste explique deux phénomènes cruciaux que les entreprises doivent connaître : l’hallucination et le biais. Quand les données sont insuffisantes, imprécises ou orientées, la réponse générée l’est aussi. Et aucune éthique ne compensera une mauvaise spécification des données.

Notion de fine tuning de l’IA – université de Limoges

La notion de fine-tuning — ajuster un modèle sur des données plus spécifiques — sera un autre point central. Dans le droit, la santé, les ressources humaines ou la comptabilité, il ne s’agit pas de “brancher une IA”. Il faut définir exactement ce qu’on veut qu’elle sache, ce qu’on lui interdit, et comment elle pilote ses sources. Sans cette étape, l’illusion de maîtrise remplace la gouvernance. Et les risques apparaissent : décisions automatisées opaques, discrimination involontaire, reproduction de normes injustes.

Dans l’esprit du colloque du CREOP à l’Université de Limoges, la perspective critique ne vise pas à ralentir l’innovation, mais à rendre visible la zone de fragilité. Marianne Dabbadie insistera sur l’esprit critique comme compétence de base : vérifier les affirmations, demander les sources, questionner la cohérence d’une réponse automatique. Une IA qui hallucine n’est pas dangereuse en soi ; une entreprise qui lui délègue une décision sans contrôle, oui.

C’est là que ce colloque prend toute son importance : croiser ces questions techniques avec le droit du travail, la responsabilité des entreprises et la protection des droits humains. Entre juristes, universitaires, avocats, économistes, médecins et dirigeants, le débat ne sera pas théorique. Il posera la bonne question : comment intégrer l’IA dans nos organisations sans perdre la capacité d’analyse et de décision humaine ?